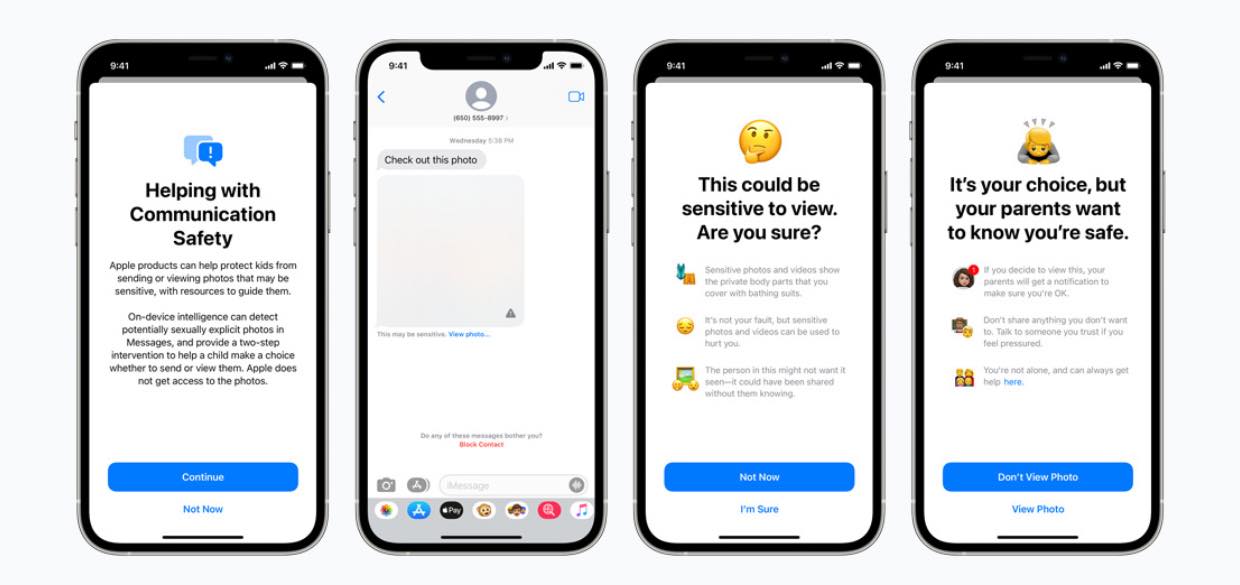

Een door Apple aangekondigde functie, waarbij iPhone-foto’s worden gescand op beelden van kindermisbruik, heeft geleid tot ophef. Worden alle foto’s dan straks gescand? En is dit het begin van meer controle op de foto’s van gebruikers? In een FAQ geeft Apple antwoord.

Lees verder na de advertentie.

Steun iPhoned

Je gebruikt een adblocker. Dat vinden we jammer, want advertenties hebben we nodig om onze artikelen gratis aan te bieden. Steun iPhoned door ons aan je whitelist toe te voegen. Alvast bedankt!

FAQ over scannen iPhone-foto’s

Deze week kondigde Apple aan dat foto’s die worden opgeslagen in iCloud, in de Verenigde Staten zullen worden gescand op beelden van kindermisbruik. Later volgen meer landen. Het scannen doet Apple met speciale software – NeuralHash genaamd. Die vergelijkt de foto’s met een database waarin beelden van kindermisbruik staan.

Het programma legt overigens geen plaatjes naast elkaar, maar hashes. Dit is een soort digitale vingerafdruk die elke foto heeft. Komen de hashes (een soort code) overeen, dan wordt Apple op de hoogte gesteld en zal het bedrijf de autoriteiten waarschuwen.

Ondanks de goede bedoelingen, klommen critici in de pen. Autoritaire regimes zouden Apple namelijk kunnen dwingen om de software voor andere doeleinden in te zetten. Bijvoorbeeld om mensen met politiek afwijkende meningen op te sporen. En iPhone-gebruikers vragen zich af of hun foto’s nog wel privé zijn.

Om de zorgen weg te nemen, schept Apple in een FAQ duidelijkheid. De interessantste vragen en antwoorden vatten we hieronder samen.

1. Scant Apple alle foto’s die op mijn iPhone zijn opgeslagen? Nee. De functie is alleen van toepassing op foto’s die de gebruiker uploadt naar iCloud-foto’s. En zelfs dan wordt Apple alleen geïnformeerd over accounts die bekende CSAM (Child Sexual Abuse Material, red) in de bibliotheek hebben staan. Het systeem werkt niet bij gebruikers die iCloud-foto’s hebben uitgeschakeld.’

2. Worden er CSAM-afbeeldingen gedownload op mijn iPhone, om te vergelijken met mijn foto’s? Nee. CSAM-afbeeldingen worden niet opgeslagen of verzonden naar het apparaat. In plaats van echte afbeeldingen, gebruikt Apple onleesbare hashes die op het apparaat zijn opgeslagen. Deze hashes zijn reeksen getallen die bekende CSAM-afbeeldingen vertegenwoordigen, maar het is niet mogelijk om die hashes te lezen of om te zetten in CSAM-afbeeldingen.

De sets hashes zijn gebaseerd op afbeeldingen die door instanties zijn verkregen en gevalideerd als CSAM. Door nieuwe cryptografische technieken te gebruiken, kan Apple deze hashes inzetten om te leren over iCloud Foto’s-accounts met bekend CSAM-materiaal. Apple detecteert alleen foto’s die bekend zijn met CSAM, zonder te leren over andere foto’s.

3. Kan de CSAM-detectie worden gebruikt om andere dingen dan CSAM te detecteren? Ons proces is ontworpen om dat de voorkomen. CSAM-detectie voor iCloud-foto’s is zo gebouwd dat het systeem alleen werkt met CSAM-hashes die worden geleverd door NCMEC (een meldpunt voor kindermisbruik) en andere organisaties voor kinderveiligheid.

Er is geen geautomatiseerde rapportage aan de autoriteiten; Apple voert een menselijke beoordeling uit voordat een melding wordt gedaan bij NCMEC. In de meeste landen, waaronder de Verenigde Staten, is eenvoudigweg het bezit van CSAM een misdaad en is Apple verplicht om alle gevallen te melden aan de beoogde autoriteiten.

4. Kunnen overheden Apple dwingen om andere soorten foto’s op te sporen? Apple zal zulke verzoeken afwijzen. We hebben vaker te maken gehad met eisen van de overheid die de privacy van gebruikers aantasten, en we hebben ze standvastig afgewezen.

We zullen ze in de toekomst blijven weigeren. Laten we duidelijk zijn: deze techniek is beperkt tot het detecteren van CSAM in iCloud-foto’s en we zullen niet ingaan op verzoeken om het uit te breiden.

5. Zal CSAM-detectie in iCloud-foto’s onschuldige mensen aangeven bij de politie? Nee. De techniek is ontworpen om zeer nauwkeurig te zijn en de kans dat het systeem een account ten onrechte als verdacht markeert, is minder dan één op één biljoen per jaar.

Bovendien voert Apple een menselijke beoordeling uit voordat een melding wordt gedaan bij het NCMEC. Als gevolg hiervan zullen systeemfouten of aanvallen er niet toe leiden dat onschuldige mensen worden gemeld bij het NCMEC.

6. Komt de CSAM-detectie ook naar Nederland en België? De CSAM-detectie doet in eerste instantie alleen zijn werk in de Verenigde Staten, maar de tech-gigant wil dit later uitbreiden naar meer landen.

Het is nog maar zeer de vraag of het detecteren van iCloud-foto’s op kindermisbruik straks ook in deze regionen van de wereld gebeurt. Dit heeft alles te maken met de AVG, de Europese privacywet. ‘In Europa zitten we met de AVG’ zoals het er nu voor staat steekt die hier een stokje voor’, meldt Peter Krager tegenover BNR, een specialist in privacyrecht.

Apple zou de software hier niet mogen toepassen, omdat de tech-gigant de foto’s eerst zelf controleert, voordat de autoriteiten worden ingeschakeld. En dat mag niet. ‘Een private organisatie die helpt bij de handhaving, zoals Apple, zou kunnen, maar dan moet daar wel een wetgeving voor komen’, oordeelt Krager.

Op de hoogte blijven van het laatste Apple-nieuws? Download dan de iPhoned-app of schrijf je in voor de nieuwsbrief.

Steun iPhoned

Je gebruikt een adblocker. Dat vinden we jammer, want advertenties hebben we nodig om onze artikelen gratis aan te bieden. Steun iPhoned door ons aan je whitelist toe te voegen. Alvast bedankt!